Tháng 5-2024, các "ông lớn" công nghệ nổi tiếng thế giới đã nối gót nhau ra mắt phiên bản trí tuệ nhân tạo (AI) mới, như OpenAI với GPT-4o, Google với Gemini 1.5 Pro... được bổ sung nhiều tính năng "siêu thông minh" để tối ưu hóa trải nghiệm của người dùng. Dẫu vậy, không thể phủ nhận công nghệ này đang bị tội phạm mạng sử dụng với nhiều kịch bản lừa đảo trực tuyến.

Rủi ro ngày càng tăng

Phát biểu tại một hội thảo mới đây, Thứ trưởng Bộ Thông tin và Truyền thông Phạm Đức Long nêu thực trạng các cuộc tấn công mạng liên tục gia tăng với mức độ ngày càng tinh vi, phức tạp. Đặc biệt, khi có sự hỗ trợ của AI, nguy cơ mà người dùng phải đối mặt sẽ tăng theo cấp số nhân. "Công nghệ AI đang bị tội phạm mạng sử dụng để dễ dàng tạo ra các phần mềm độc hại mới, các cuộc tấn công lừa đảo mới, tinh vi..." - Thứ trưởng Phạm Đức Long cảnh báo.

Theo báo cáo của Cục An toàn thông tin - Bộ Thông tin và Truyền thông, rủi ro về an toàn an ninh mạng có liên quan AI đã gây thiệt hại hơn 1 triệu tỉ USD cho toàn thế giới, trong đó riêng Việt Nam là 8.000 - 10.000 tỉ đồng. Phổ biến nhất hiện nay là tình trạng sử dụng AI để giả mạo giọng nói và khuôn mặt nhằm mục đích lừa đảo. Dự báo đến năm 2025 sẽ có khoảng 3.000 cuộc tấn công/giây, 12 mã độc/giây và 70 lỗ hổng, điểm yếu mới/ngày.

Theo ông Nguyễn Hữu Giáp, Giám đốc BShield - chuyên hỗ trợ bảo mật cho các ứng dụng, việc tạo ra hình ảnh, giọng nói giả mạo hiện không khó với sự tiến bộ của AI. Kẻ gian có thể dễ dàng thu thập dữ liệu người dùng từ thông tin công khai mà họ đăng trên mạng xã hội hoặc qua các chiêu thức như phỏng vấn tuyển dụng online, gọi điện thoại dưới danh nghĩa "cơ quan chức năng". Trong một mô phỏng được BShield thực hiện, từ khuôn mặt có sẵn qua một cuộc gọi video, kẻ gian có thể đưa chúng vào giấy CCCD, ghép vào thân hình một người cử động để lừa công cụ eKYC và được hệ thống nhận định là người thật.

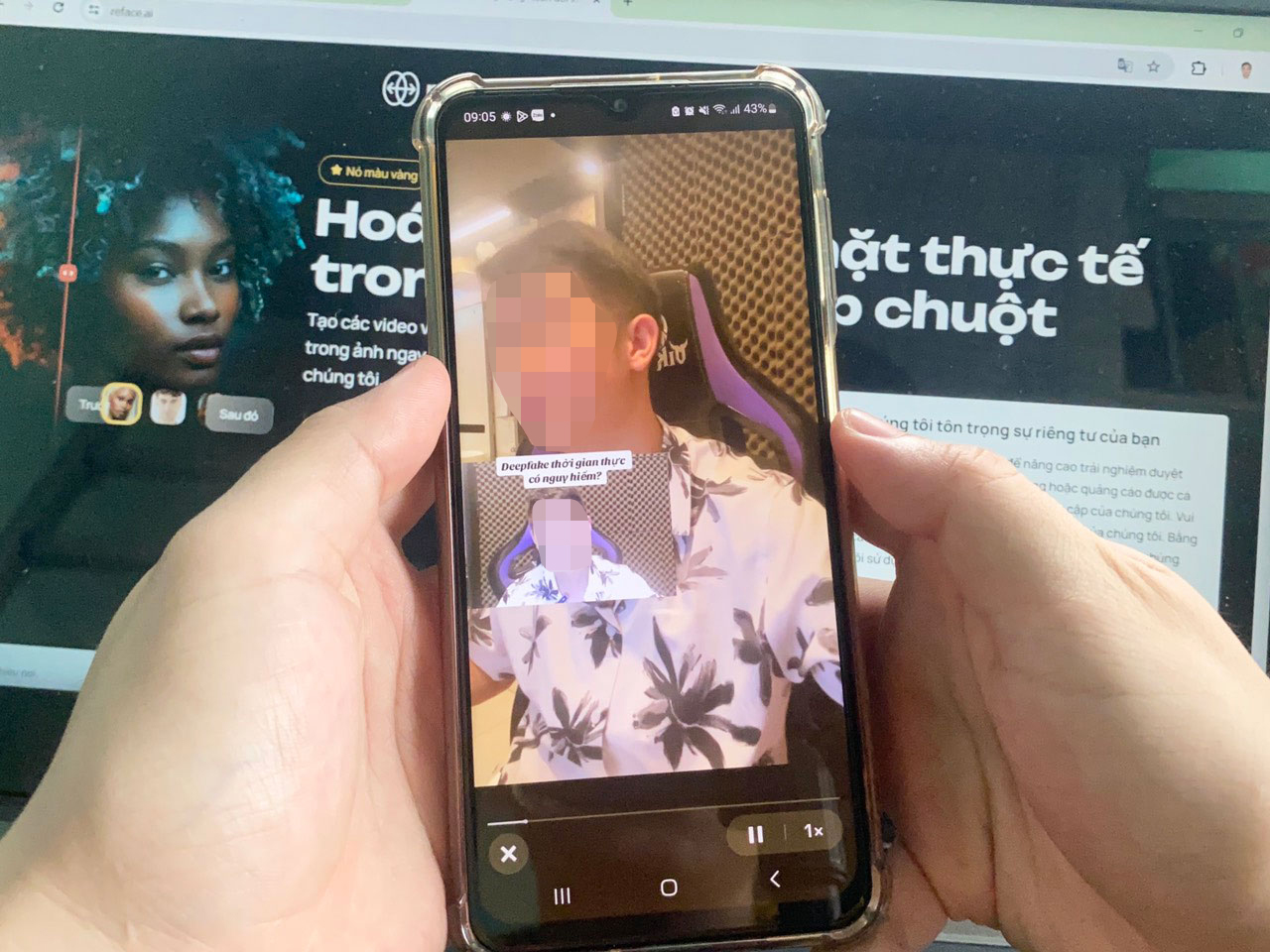

Thủ đoạn lừa đảo bằng công nghệ deepfake ngày càng gia tăng và tinh vi Ảnh: LÊ TỈNH

Ở góc độ người dùng, ông Nguyễn Thành Trung, chuyên viên công nghệ thông tin tại TP HCM, lo ngại khi đối tượng xấu có thể lợi dụng chatGPT tạo ra email lừa đảo với nội dung và phong cách viết giống email thật của các ngân hàng hay đơn vị uy tín. Các email này có khả năng được đính kèm phần mềm độc hại, nếu người dùng nhấp vào thì chắc chắn bị đánh cắp dữ liệu, chiếm đoạt tài sản. "Các phần mềm AI ngày càng được cải tiến, có thể tạo ra video giả mạo khuôn mặt và giọng nói giống người thật đến 95%, cử chỉ thay đổi theo thời gian thực khiến người xem rất khó phát hiện" - ông Trung nói.

Sớm hoàn thiện hành lang pháp lý

Để hạn chế rủi ro lừa đảo công nghệ cao, chuyên gia bảo mật Phạm Đình Thắng lưu ý người dùng cần thường xuyên cập nhật kiến thức về AI, không nhấp vào link không rõ nguồn gốc. Đối với doanh nghiệp (DN), nên bố trí ngân sách để phục vụ việc bảo đảm an toàn dữ liệu và vận hành hệ thống. Nhân sự của DN cũng cần được đào tạo, tập huấn theo chiều sâu để tiếp cận được các lỗ hổng thực tế đang xảy ra trong hệ thống, tăng khả năng nhận dạng các loại hình tấn công trên mạng.

Ông Tạ Công Sơn, Trưởng Phòng Phát triển AI - dự án Chống lừa đảo, cho rằng AI đã và đang đi sâu vào đời sống của người dùng và hoạt động của DN, cơ quan, đơn vị nhờ những tính năng hỗ trợ vô cùng thông minh. Đáng chú ý, công nghệ AI hiện nay rất dễ tiếp cận, sử dụng nên sẽ tạo điều kiện cho các đối tượng xấu dễ dàng lợi dụng nhằm mục đích lừa đảo. "Kẻ lừa đảo cũng liên tục thay đổi phương thức tấn công, người dùng phải cập nhật thông tin thường xuyên để biết cách phòng tránh" - ông Sơn khuyến nghị.

Theo các chuyên gia, model GPT-4o, Gemini 1.5 Pro... được nâng cấp vượt trội mới đây đã chứng tỏ sự thông minh của AI là không có giới hạn. Do đó, bên cạnh khuyến khích DN phát triển công cụ và giải pháp chống lừa đảo AI, cơ quan quản lý cần sớm hoàn thiện hành lang pháp lý về AI để đón đầu xu thế.

Thượng tá Nguyễn Anh Tuấn, Phó Giám đốc Trung tâm Dữ liệu quốc gia về dân cư, cho rằng cần sớm ban hành văn bản quy định về đạo đức, trách nhiệm của nhà cung cấp dịch vụ trong và ngoài nước trong quá trình phát triển, sản xuất, ứng dụng, sử dụng AI. Đồng thời, cần có quy định cụ thể về tiêu chuẩn kỹ thuật đối với các hệ thống có sử dụng, ứng dụng, kết nối, cung cấp dịch vụ AI. "Cần nghiên cứu, ứng dụng các công trình AI để chống lại rủi ro về AI. Bởi vì AI được tạo ra bởi con người, là sản phẩm của tri thức, sẽ có những biến thể "AI tốt" và "AI xấu" nên có thể ngăn cản sự phát triển của trí tuệ nhân tạo bằng chính trí tuệ nhân tạo" - thượng tá Tuấn lưu ý.

Thách thức về an ninh mạng

Thượng tá Nguyễn Anh Tuấn nhìn nhận AI đang đặt ra những thách thức về an ninh mạng. Theo đó, những phần mềm độc hại được hỗ trợ bởi AI có thể được cài vào các file tài liệu, khi người dùng đăng tải file tài liệu thì mã độc này sẽ xâm nhập hệ thống. Bên cạnh đó, từ các công nghệ đặc biệt của AI, hacker có thể mô phỏng hệ thống, tấn công vào các lỗ hổng bảo mật. AI có thể tạo ra nhiều ứng dụng có hình ảnh, tên giả mạo các ứng dụng, trang web của Bộ Công an để người dân tải về, cài đặt và cung cấp các thông tin như số CCCD, mật khẩu đăng nhập. "AI cũng sẽ tự phát triển các phần mềm, mã độc lai tạo giữa nhiều dòng mã độc, có cơ chế né tránh bảo mật tinh vi hơn, tự động thay đổi các mã nguồn linh hoạt" - thượng tá Nguyễn Anh Tuấn khuyến cáo.